Inhalt

- Was ist robots.txt?

- So richten Sie eine robots.txt-Datei ein

- Der Inhalt einer robots.txt-Datei

- Erstellen einer robots.txt-Datei

- VIDEO: So erstellen Sie eine robots.txt-Datei

- Testen Ihrer robots.txt-Datei

- Die GOTCHAs, die mich erwischt haben!

- Meine robots.txt-Datei hat nicht funktioniert!

- Im unzulässigen Ordner oder im Dateinamen sind keine Leerzeichen zulässig

- robots.txt macht seinen Job

Ron ist ein pensionierter Ingenieur und Manager für IBM und andere High-Tech-Unternehmen. Er spezialisierte sich sowohl auf Hardware- als auch auf Softwaredesign.

Als Autor, der Artikel auf verschiedenen Websites im Internet verfasst, wollte ich ein Online-Archiv für meine Arbeit einrichten. Dies wäre ein Repository, auf das ich anderen bei Bedarf Zugriff gewähren könnte. Ein Beispiel wäre die Einrichtung einer Urheberschaft in Fällen von Urheberrechtsverletzungen (DMCA). Gleichzeitig musste ich verhindern, dass die Dateien in meinem Archiv von Suchmaschinen wie Google oder Bing indiziert werden, um zu vermeiden, dass doppelte Dateien mit demselben Inhalt in den Suchergebnissen angezeigt werden.

Eine kleine Untersuchung hat gezeigt, dass mit a robots.txt Datei könnte ich Suchmaschinen informieren, dass sie bestimmte Elemente auf meiner Website nicht indizieren sollten. Es ist eine einfache Lösung, die genau das tut, wofür ich sie brauche. Beim Einrichten meiner robots.txt-Datei stieß ich jedoch auf einige Probleme, die in der von mir gelesenen Dokumentation nicht behandelt wurden und die einige Zeit und Kopfkratzer erforderten, um sie durch Ausprobieren herauszufinden.

Aus diesem Grund hielt ich es für nützlich, einen einfachen Leitfaden bereitzustellen, der es anderen erspart, sich mit den Problemen zu befassen, die ich getan habe.

Was ist robots.txt?

Suchmaschinen verwenden Anwendungen, die als "Roboter" bezeichnet werden, um das gesamte Internet zu "crawlen", Online-Dateien zu durchsuchen und sie einer Datenbank hinzuzufügen. Wenn ein Nutzer beispielsweise einen Suchbegriff in Google eingibt, wird diese Abfrage mit der Datenbank der von Google gecrawlten Websites abgeglichen. Aus dieser internen Datenbank wird eine Liste der Suchergebnisse für den Benutzer erstellt.

Die robot.txt-Datei wird verwendet, um im Wesentlichen ein KEEP OUT-Zeichen für Dateien auf Ihrer Website anzubringen, die Suchmaschinenroboter nicht sehen sollen. Da diese Dateien vom Roboter übersprungen werden, werden sie nicht in der Datenbank der Suchmaschine indiziert und nicht in den Suchergebnissen angezeigt.

Seriöse Suchmaschinen programmieren alle ihre Roboter so, dass sie auf jeder Website, die sie finden, nach der Datei robot.txt suchen. Wenn diese Datei vorhanden ist, befolgt der Roboter seine Anweisungen bezüglich aller Dateien oder Ordner, die der Roboter überspringen sollte.

(Beachten Sie, dass dies alles von Seiten der Suchmaschine völlig freiwillig ist. Schurken-Suchmaschinen können und ignorieren die Anweisungen in robot.txt. Tatsächlich können einige Bösewichte tatsächlich von den Teilen Ihrer Website angezogen werden, zu denen robot.txt sagt Vermeiden Sie die Theorie, dass, wenn Sie es verbergen möchten, möglicherweise etwas vorhanden ist, das sie ausnutzen können.

So richten Sie eine robots.txt-Datei ein

Ich werde beschreiben, wie ich meine robots.txt-Datei eingerichtet habe, um meinen spezifischen Anforderungen gerecht zu werden. Hier finden Sie eine allgemeinere Beschreibung der verschiedenen Verwendungsmöglichkeiten von robots.txt. Beachten Sie, dass Sie zur Verwendung dieser Methode eine eigene Website mit einem eigenen Domainnamen haben müssen.

Die Verwendung von robots.txt zum Einschränken des Zugriffs auf Ihre Dateien funktioniert nur, wenn Sie eine eigene Website mit einem eigenen Domainnamen haben. Dies liegt daran, dass sich die Datei robots.txt nur im obersten Verzeichnis Ihrer Website befinden kann und Sie nur dann Änderungen an diesem Verzeichnis vornehmen können, wenn Sie Eigentümer der Website sind.

Zum Beispiel, wenn Ihre Website ist

http://www.myownwebsite.com

dann muss die robots.txt-Datei den Namen haben

http://www.myownwebsite.com/robots.txt

Wenn Sie Ihre robots.txt-Datei an einer anderen Stelle auf der Website ablegen, wird sie nicht erkannt. Wenn Sie beispielsweise Ihre robots.txt in einem Ordner namens mygoodstuff ablegen,

http://www.myownwebsite.com/mygoodstuff/robots.txt

oder in eine Subdomain wie

http: //www.mygoodstuff/myownwebsite.com/robots.txt

Web-Crawler erkennen es nicht und befolgen die Anweisungen nicht.

Aufgrund dieser Einschränkung können Sie dies nicht mit einer kostenlosen Wordpress-Site wie https://myfreewebsite.wordpress.com tun. Sie können die robots.txt-Datei auf wordpress.com (https://wordpress.com/robots.txt) sehen, aber nicht ändern.

Wenn Sie die Datei wordpress.com robots.txt anzeigen möchten, geben Sie einfach https://wordpress.com/robots.txt in das URL-Feld Ihres Browsers ein und drücken Sie die Eingabetaste. Sie können den Inhalt der Datei sehen, aber nicht ändern.

Beachten Sie auch, dass die Großschreibung wichtig ist! Der Dateiname muss robots.txt sein und sonst nichts. ROBOTS.TXT oder Robots.Txt funktionieren nicht.

Der Inhalt einer robots.txt-Datei

So könnte der Inhalt einer typischen robots.txt-Datei aussehen:

User-Agent: *

Nicht zulassen: / Ordner zum Ignorieren /

Das User-Agent Begriff gibt die speziellen Suchmaschinen an, an die diese Richtlinie gerichtet ist. Das * im obigen Beispiel bedeutet, dass es für alle Suchmaschinen gilt. Wenn Sie beispielsweise möchten, dass Ihre Anweisungen nur für Google gelten, verwenden Sie Folgendes:

User-Agent: Google

Nicht zulassen: / Ordner zum Ignorieren /

Dies würde nur Google und keine anderen Suchmaschinen daran hindern, auf die von Ihnen aufgelisteten Ordner oder Dateien zuzugreifen.

Das Nicht verbieten Begriff gibt an, welche Ordner oder Dateien vom Roboter nicht durchsucht oder erkannt werden sollen. Im obigen Beispiel möchte ich nicht, dass der Inhalt eines Ordners aufgerufen wird Ordner zu ignorieren von Suchmaschinen indiziert werden. Daher weist meine Disallow-Anweisung Webcrawler an, die folgende URL zu ignorieren:

http://www.myownwebsite.com/folder-to-ignore/

Es können mehrere Ordner oder Dateien angegeben werden:

User-Agent: *

Nicht zulassen: / Ordner zum Ignorieren /

Nicht zulassen: / another-folder /

Nicht zulassen: / dritter Ordner / Unterordner /

Nicht zulassen: /some-folder/myfile.html

Erstellen einer robots.txt-Datei

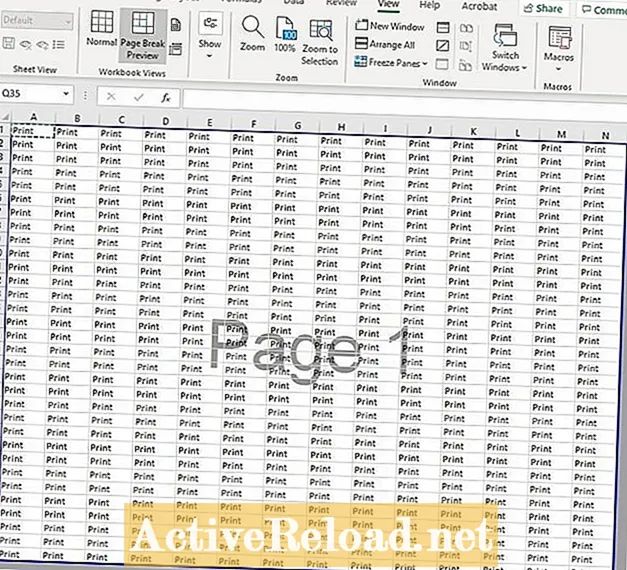

Jeder Texteditor, wie z. B. NotePad in Windows, kann zum Erstellen von robot.txt-Dateien verwendet werden. Beachten Sie, dass bei Verwendung eines Dokumenteditors wie Microsoft Word die Ausgabe als TXT-Datei gespeichert werden muss. Andernfalls enthält die Datei möglicherweise versteckte Codes, die den Inhalt ungültig machen.

Nach dem Speichern als Text muss die Datei in das oberste Verzeichnis Ihrer Website hochgeladen werden. Auf den meisten Servern ist dies der Ordner public_html.

Laden Sie robots.txt genauso hoch, wie Sie normalerweise Dateien auf die Site hochladen. In den meisten Fällen wird dazu eine FTP-App wie der kostenlose Open-Source-FileZilla-Client verwendet. Stellen Sie sicher, dass die Datei im richtigen Ordner abgelegt ist.

VIDEO: So erstellen Sie eine robots.txt-Datei

Testen Ihrer robots.txt-Datei

Es ist sehr wichtig, dass Sie Ihr robots.txt-Setup testen, um sicherzustellen, dass es wie gewünscht funktioniert. Andernfalls stellen Sie möglicherweise fest, dass die Ordner, die Sie blockieren möchten, für Crawler weiterhin zugänglich sind und in den Suchergebnissen angezeigt werden. In diesem Fall kann es Wochen oder sogar Monate dauern, bis sie aus der Datenbank der Suchmaschine entfernt werden.

Im Internet stehen mehrere kostenlose robots.txt-Tester zur Verfügung. Hier sind die, die ich verwendet habe:

Robots.txt-Tester für die Webmaster-Tools von Google (erfordert ein Google-Konto)

http://www.searchenginepromotionhelp.com/m/robots-text-tester/robots-checker.php

Die GOTCHAs, die mich erwischt haben!

Google konnte meine robots.txt-Datei nicht sehen

Ich habe meine robots.txt-Datei so eingerichtet, dass ein Ordner namens blockiert wird / YCN-Archiv /. Ich habe diesen Ordner auf meiner Website erstellt und überprüft, ob wie erwartet darauf zugegriffen werden kann.

Ich habe dann eine robots.txt-Datei mit folgendem Inhalt erstellt:

User-Agent: *

Nicht zulassen: / YCN Archive /

Nachdem ich diese Datei in mein oberstes Verzeichnis hochgeladen habe, habe ich sie mit dem robots.txt-Tester in den Webmaster-Tools von Google getestet. Obwohl ich die Anweisungen über den obigen Link zu den Webmaster-Tools genau befolgt habe, bin ich sofort auf ein Problem gestoßen. Hier ist die völlig unerwartete Fehlermeldung, die ich erhalten habe:

Aber die robot.txt war da! Ich konnte es in der Dateiliste meiner Website sehen, genau dort, wo es sein sollte. Warum konnte Google es nicht sehen? Schließlich sah ich etwas auf der Testerseite, das ich vorher nicht bemerkt hatte.

Der Schlüssel befand sich in der Zeile „Neueste Version vom 26.07.14…“ (ich habe den Test einige Tage nach dem 26.07. Durchgeführt). Als ich den Test startete, hat Google anscheinend den Status der Website in diesem Moment nicht überprüft, sondern sich anscheinend auf das interne Bild verlassen, wie die Website beim letzten Crawlen ausgesehen hat.

Ich brauchte Google, um ein aktuelles Bild von meiner Website zu erhalten. Ich habe dies durch die Verwendung der Funktion "Abrufen als Google" verursacht.

Nachdem die Funktion Als Google abrufen ausgeführt wurde, konnte Google die Datei robots.txt finden.

Hier ist ein weiterer Punkt, auf den Sie achten sollten. Im robots.txt-Tester hat Google meine Website auf zwei verschiedene Arten aufgelistet:

myownwebsite.org

http://myownwebsite.org

Natürlich beziehen sich beide Einträge auf genau dieselbe URL. Aber ich musste für jeden einzelne Google-Abrufe durchführen, damit die robots.txt-Datei erkannt wurde. Ich habe auch jeweils separate Tests durchgeführt, um sicherzustellen, dass meine Blockierungsanweisungen ausgeführt werden, unabhängig davon, welche URL für den Zugriff auf die Site verwendet wurde.

Meine robots.txt-Datei hat nicht funktioniert!

Nachdem Google meine robots.txt-Datei sehen konnte, führte ich den Test aus und war mir des Erfolgs sicher. Es hat immer noch nicht funktioniert. Diesmal ergab der Test, dass meine robots.txt zwar jetzt erkannt wurde, jedoch den Zugriff auf den Ordner / YCN Archive / nicht blockierte. Der Webcrawler-Zugriff auf diesen Ordner war weiterhin "ERLAUBT".

Im unzulässigen Ordner oder im Dateinamen sind keine Leerzeichen zulässig

Ich wusste, dass meine robots.txt korrekt eingerichtet war, daher war ich verblüfft, warum sie den Zugriff auf den angegebenen Ordner nicht blockierte. Ich brauchte einige Zeit, um herauszufinden, was los war. Mein Ordner hatte ein Leerzeichen im Namen! Als ich den Ordner umbenannte, um den Speicherplatz zu entfernen, zeigte der Google robots.txt-Tester den Ordner als blockiert an.

robots.txt macht seinen Job

Seit ich meine robot.txt eingerichtet habe, hat sie ihre Arbeit lautlos und effizient erledigt. Meine Dateien werden sicher online archiviert und können von jedem abgerufen werden, dem ich die URL gebe. Aber keiner von ihnen wird in Suchmaschinenergebnissen angezeigt.

Dieser Artikel ist genau und nach bestem Wissen des Autors. Der Inhalt dient nur zu Informations- oder Unterhaltungszwecken und ersetzt nicht die persönliche Beratung oder professionelle Beratung in geschäftlichen, finanziellen, rechtlichen oder technischen Angelegenheiten.